La complexité des processus atteint des sommets

La digitalisation a transformé profondément l’organisation de l’ensemble des secteurs économiques, la phase d’adaptation des organisations étant toujours en cours.

Personne ne remet en question ses avantages et son apport considérable. Les entreprises et le secteur public ont adopté à marche forcée de nouvelles organisations, de nouvelles façons de travailler et créé de nouveaux systèmes d’information.

De très importants investissements ont été consentis en solutions informatiques (ERP, CRM, outils fronts, workflow, solutions de BI, …).

Des adaptations bénéfiques, mais qui ont également produit un niveau de complexité jusqu’alors inégalé.

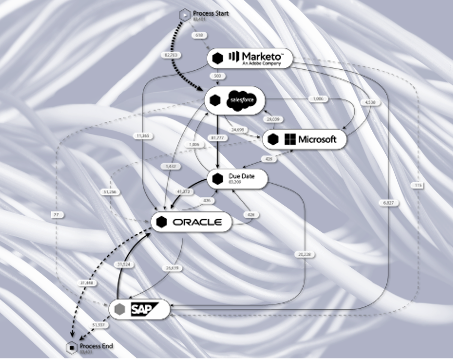

Les processus opérationnels parcourent actuellement de multiples systèmes d’information. Par exemple, servir un client passe aujourd’hui par une myriade d’applications : CRM, ERP, outil de ticketing, mail, tableur, etc. Ceci sans compter les échanges internes à l’organisation qui mobilisent d’autres briques : messagerie, outils de chat en ligne…

Finalement, mieux opérer, à des niveaux de coûts toujours sous pression, et en respectant la promesse client passe par une maîtrise de bout en bout des processus opérationnels. Les exigences règlementaires et de conformité doivent également être assurée, sans défaut et avec un niveau de productivité optimal.

La recherche de performance opérationnelle plafonne

Les initiatives de recherche d’excellence opérationnelle ont traditionnellement été conduites à petite échelle (améliorer un processus ou une fraction de celui-ci) ou dans une approche top-down qui peine à produire des effets opérationnels tangibles et pérennes.

Ces logiques passent la plupart du temps par de multiples étapes : collecte des informations et modélisation des processus existants, recensement des inefficacités, modélisation des processus cibles, projets d’amélioration, …

L’expérience montre que ces démarches sont longues et couteuses et qu’elles ne produisent qu’une fraction de l’amélioration nécessaire ou souhaitée.

Elles butent sur des limites :

- une vision subjective et partielle des processus : elle repose sur le savoir de quelques-uns voire leur ressenti. Les écarts dans l’exécution des processus ne sont pas tous connus ou leurs impacts mal estimés.

- une décorrélation entre les actions de terrain, le niveau de pilotage des managers et les objectifs stratégiques,

- un retour sur investissement souvent questionné en raison de coûts de projet élevés et d’un apport de valeur qui n’est pas toujours démontré,

- une difficulté grandissante à orchestrer, à l’échelle, l’amélioration continue.

Les méthodes et outils utilisés jusqu’à présent ne sont plus en mesure de répondre à ces nouveaux défis. Les organisations doivent prendre un virage leur permettant de s’appuyer sur la technologie rendue possible par l’intelligence artificielle et le machine learning. Exploiter le gisement des données générées par leurs systèmes d’information pour en tirer de la valeur opérationnelle est maintenant possible grâce notamment au process mining.

Le Process Mining, un game changer pour produire de la valeur

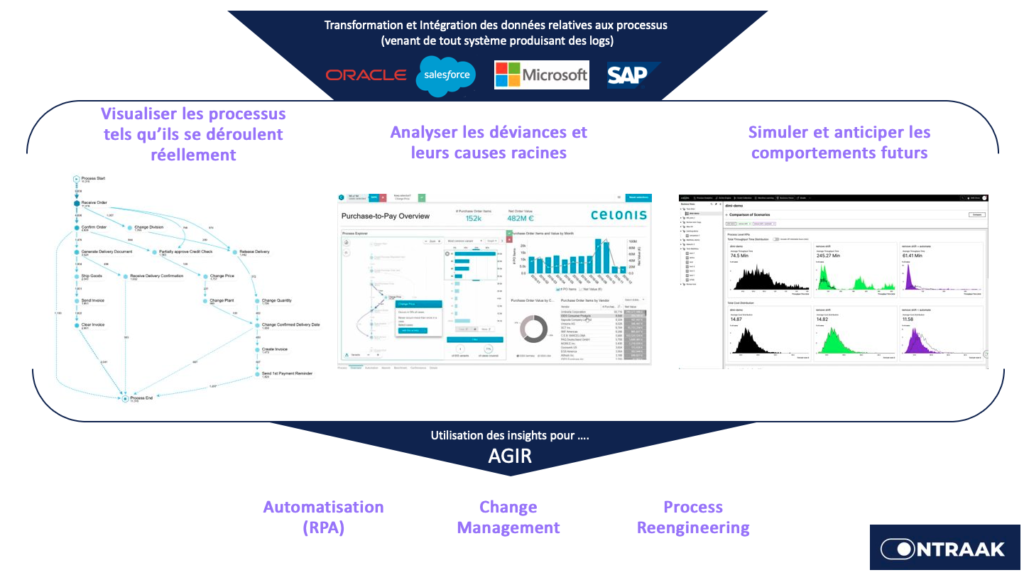

Qu’est-ce que le process mining ? L’idée maîtresse est d’utiliser l’énorme masse de données produite par les systèmes d’informations pour obtenir une connaissance exhaustive de l’exécution des processus. Couplée à la data science, elle permet de conduire des diagnostics et de simuler les comportements futurs.

Le process mining, c’est la Data Science en action.

Will van der Aalst, pape du process mining

De manière concrète, la représentation exhaustive des processus réels, alliée à de puissantes fonctions de machine learning, aide à poser un diagnostic accéléré des déviances et de leurs impacts sur les indicateurs de performance propres à chaque métier.

Cette phase de diagnostic produite en quelques jours ou semaines selon la complexité du système d’information permet de sélectionner les actions d’amélioration dans une logique de « quick wins ».

Le process mining permet d’aborder ce type d’initiative par la réalité opérationnelle. En se fondant sur les données issues de l’exécution des processus (l’empreinte digitale ou digital footprint), la démarche évite la subjectivité et les coûts importants constatés sur ce type de projet.

Les actions améliorant l’efficience peuvent donc être ciblées de façon précise sur les difficultés identifiées. Celles-ci peuvent prendre la forme de formation des équipes, d’amélioration des processus, ou de mise en place de solutions d’automatisation grâce au RPA.

Cette démarche outillée et novatrice de mise en œuvre de la performance opérationnelle nous permet d’obtenir des résultats rapidement ; en l’espace de quelques semaines seulement.

Une nouvelle dynamique opérationnelle

Au-delà des premiers résultats rapides que nous sommes capables de produire, cette démarche aide à insuffler une nouvelle dynamique d’amélioration continue au sein de l’entreprise.

Certains métiers ou secteurs montrent des difficultés à instaurer et pérenniser une culture d’amélioration continue. Celle-ci est rendue possible par l’extension de la démarche à d’autres processus, à d’autres périmètres. Les indicateurs étant produits en temps réels sur la base des processus pris en charge, toute dégradation ultérieure est visible.

L’expérience montre que la meilleure manière d’y parvenir est d’intégrer dans l’organisation un Centre d’Excellence en charge des différentes initiatives visant une performance opérationnelle augmentée :

- Le recensement et la préparation des données nécessaires,

- La connaissance des processus par l’utilisation du process mining,

- L’identification et la mise en œuvre des actions d’amélioration (re-engeenering de processus, change management, RPA, …)

- Le pilotage de l’amélioration continue à l’échelle au quotidien et dans la durée.

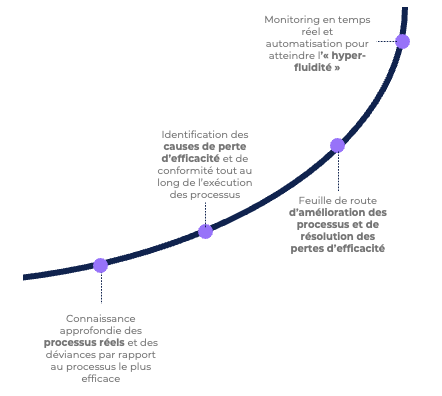

L’« Hyper Fluid Execution » comme objectif

L’état d’achèvement de notre démarche est de permettre aux organisations d’atteindre l’« Hyper-fluid execution »,.

Concrètement, cela signifie que l’organisation a une connaissance précise des processus opérationnels et est en capacité d’identifier, d’anticiper et de traiter les écarts par rapport à l’exécution idéale.

Cette nouvelle approche de l’excellence opérationnelle se fonde sur quelques axes clés :

- Une approche granulaire fondée sur le niveau d’exécution opérationnelle des processus,

- Une démarche capable d’apporter des quick wins et de passer à l’échelle,

- Des decisions « data driven » appuyées par la réalité opérationnelle et non sa perception ou son interprétation subjective,

- Des tableaux de bord stratégiques fondés sur la réalité opérationnelle ne nécessitant pas d’investissement majeurs pour la consolidation de données,

- Une orchestration à l’échelle de l’amélioration et de l’automatisation des processus,

- Une meilleure coordination globale afin de tirer le meilleur des compétences et des technologies

Grâce aux nouvelles technologies que sont le process mining, le machine learning et l’intelligence artificielle, nous sommes capables d’offrir cette promesse avec des résultats visibles en quelques semaines.